查核結果:錯誤

一分鐘完讀:

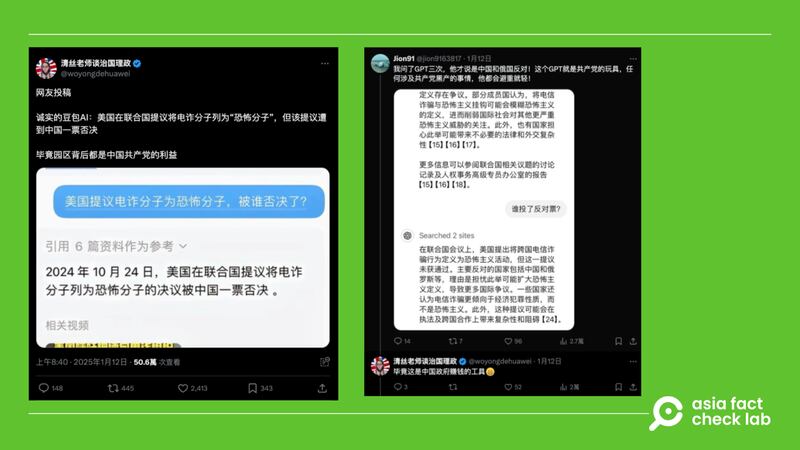

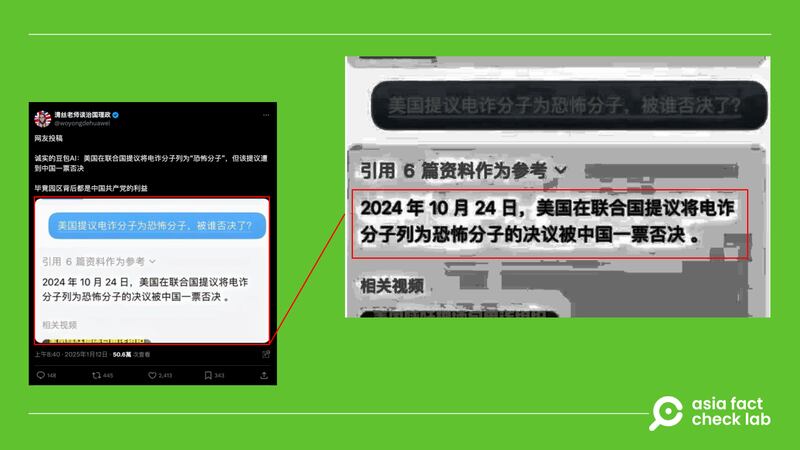

X平台上有網友表示美國曾在聯合國提議將電信詐騙分子列為恐怖分子,但被中國否決,並附上一張人與生成式AI機器人對話的內容截圖作為證據。

亞洲事實查核實驗室查閱聯合國會議記錄,確認迄今並未有任何國家正式提出要將電信詐騙分子列為恐怖分子,中國也沒有過否決該提議的記錄。此外,截圖確實與字節跳動旗下AI工具「豆包」形式相同,但以圖片鑑識工具Forensically檢測,可以發現對話有被變造的痕跡。

深度分析:

近期,中國藝人王星從緬甸詐騙園區獲救,緬甸電信詐騙問題再次受到討論。 X上有中國網友稱,以「美國提議電詐分子為恐怖分子,被誰否決了?」詢問字節跳動旗下AI「豆包」,結果是被中國否決。另外,留言處有網友稱,他以同樣問題問了OpenAI開發的ChatGPT共3次,ChatGPT才說是中國和俄國反對。

美國是否曾提議將電詐勒索者列入恐怖分子?

亞洲事實查核實驗室(以下簡稱AFCL)以關鍵字查詢,發現中國社群媒體上確實散播「美國提案將緬甸詐騙園區列為恐怖組織」的 說法,但以關鍵字查詢,近期美國官方發表與緬甸有關的言論,是美國國務院於2025年1月20日更新的 美緬關係介紹,主題在譴責緬甸政府違反人道的行為,當中並未提到有關詐騙與恐怖分子相關的言論。 AFCL以電子郵件向美國國務院查證,至截止日期前未獲回應。

而查詢聯合國安理會2024年至今的 會議紀錄,其中也沒有任何國家提案將電詐分子列為恐怖分子。

網傳「豆包」的對話截圖是否真實?

首先,AFCL以抖音上的展示影片,確認網傳截圖和字節跳動於2024年正式推出的AI工具「豆包」格式相同。但進一步利用圖片鑑識工具 Forensically 檢測,網傳截圖在 「主成份分析(Principal Component Analysis,PCA)」這項參數上,顯示有變造痕跡,高度可能經過重製。

AFCL複製實驗,在「豆包」上輸入相同的問題:「美國提議電詐分子為恐怖分子,被誰否決了?」。結果顯示「目前沒有確切消息證實美國有過這樣的提議」,也不存在提案被否決的情形。

生成式AI是否可信?

台灣中央研究院資訊科學研究所研究員 王新民依據字節跳動公開的「豆包演算法及模型備案公示說明」向AFCL解釋,豆包與目前市面上常見的大型語言模型(LLM)的原理相同,皆是使用transformer模型,以文字接龍的概念生成對話。

AFCL過去曾針對大型語言模型的原理,推出 專題報道,說明AI給的答案未必可信。以ChatGPT為例,GPT仰賴大量的網路資料學習來完成「文字接龍」,例如用戶給出「今天」,GPT便被訓練要接上「是」; 當看見「今天是」便要學會接上「星期」,循序漸進的完成「今天是星期三」的完整句子。 GPT採用文字接龍,但接續的文字有許多種組合的可能,因此模型會針對這些組合列出機率,將爬梳所有文本後較高機率的文字接龍提供給使用者,而非給出正確答案。

[ ChatGPT專題之一:當人工智能遇到敏感詞Opens in new window ]

[ ChatGPT專題之二:為什麼它有時會胡說八道?Opens in new window ]

過去AFCL也曾探討語言模型的偏見,當時台灣人工智慧實驗室創辦人杜奕瑾告訴AFCL,人工智能在做語言模型訓練時,其實會把文本內容偏見及思想學習起來,而偏見的來源即是收集來的語料庫以及人工標註,「用哪個市場訓練,就是那個地方文化思想的輸出。 」

AFCL亦發現,在與「豆包」的對答之中,其引用的參考資料皆為中國網站,王新民推測,如果僅出現中國網站,這個生成式AI在訓練時大概率僅使用中國網站的資料。

王新民亦提到,在台灣也有僅用台灣資料訓練的模式「TAIDE」。 TAIDE模式目的就是打造一個台灣在地化的AI對話引擎,促進AI模型更精準的理解與運用繁體中文,其 訓練資料有被公開披露。

亞洲事實查核實驗室(Asia Fact Check Lab)針對當今複雜媒體環境以及新興傳播生態而成立。我們本於新聞專業主義,提供專業查核報告及與信息環境相關的傳播觀察、深度報導,幫助讀者對公共議題獲得多元而全面的認識。讀者若對任何媒體及社交平台傳播的信息有疑問,歡迎以電郵 afcl@rfa.org寄給亞洲事實查核實驗室,由我們為您查證核實。

亞洲事實查核實驗室更詳細的介紹請参考 本文。我们另有X、臉書、IG頻道,歡迎讀者追蹤、分享、轉發。X這邊請進:中文 @asiafactcheckcn;英文: @AFCL_eng、 FB在這裡、 IG也別忘了。